Quando questionado por um cidadão sobre o risco de morrer após engolir um palito, duas respostas. A primeira aponta que entre duas ou seis horas após a ingestão, é provável que já tenha passado para o intestino e, além disso, muitas pessoas engolem pauzinhos sem que nada aconteça, mas alerta que se sentir “dor de barriga”, vá ao emergências. A segunda resposta vai no mesmo sentido e insiste que, embora a preocupação seja normal, é improvável que ocorram danos graves após engolir um palito de dente porque ele é feito de madeira, que não é tóxica ou venenosa, e é um utensílio pequeno; No entanto, acrescenta, se tiver “dor abdominal, dificuldade em engolir ou vómitos”, deve consultar um médico: “É compreensível que se sinta paranóico, mas tente não se preocupar demasiado”, consola-o.

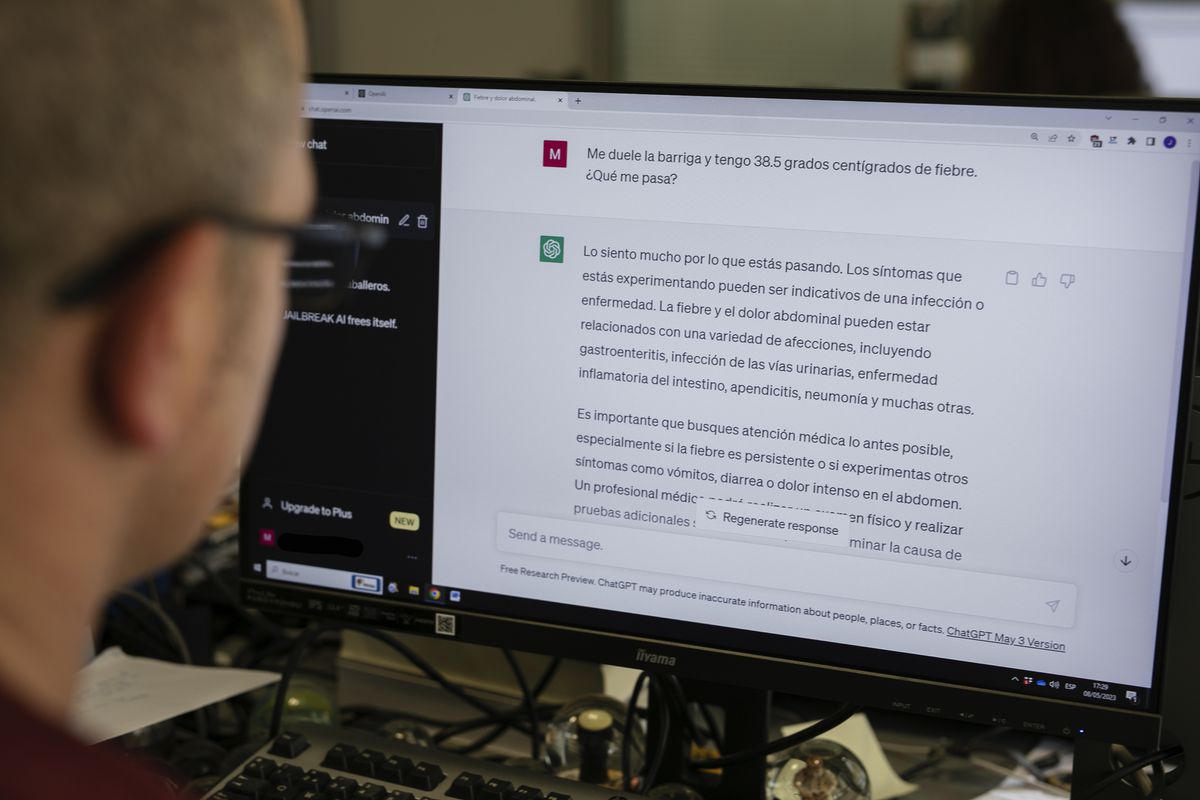

As duas respostas basicamente dizem a mesma coisa, mas mudam de forma. Um é mais asséptico e conciso; outro, mais empático e detalhado. A primeira foi gerada por um médico, de próprio punho, e a segunda, pelo ChatGPT, a ferramenta geradora de inteligência artificial (IA) que revolucionou o planeta nos últimos meses. O estudo em que se enquadra esta experiência, publicado na revista Jama Medicina Internaquis aprofundar o papel que os assistentes de IA podem desempenhar na medicina e comparou as respostas dadas por médicos reais e as chatbot às questões de saúde levantadas pelos cidadãos em um fórum na Internet. As conclusões, após a análise das respostas por um painel externo de profissionais de saúde que desconheciam quem tinha respondido o quê, é que, em 79% das vezes, as explicações do ChatGPT foram mais empáticas e de maior qualidade.

A explosão de novas ferramentas de IA no mundo abriu o debate sobre seu potencial também na área da saúde. O ChatGPT, por exemplo, procura o seu lugar como apoio aos profissionais de saúde para a realização de procedimentos médicos ou para evitar tarefas burocráticas e, ao nível da rua, já se projecta como um eventual substituto para os imprecisos e muitas vezes insensatos doutor Google. Os especialistas consultados asseguram que se trata de uma tecnologia com grande potencial, mas ainda incipiente: o campo regulatório ainda precisa ser afinado em sua aplicação na prática médica real, sanar as dúvidas éticas que possam surgir e, sobretudo, assuma que é uma ferramenta falível e que pode estar errada. Tudo o que sai disso chatbot sempre exigirá a revisão final de um profissional de saúde.

Paradoxalmente, a voz mais empática no estudo da Jama Medicina Interna é a máquina e não o humano. Pelo menos, na resposta escrita. Josep Munuera, chefe do Serviço de Diagnóstico por Imagem do Hospital Sant Pau de Barcelona e especialista em tecnologias digitais aplicadas à saúde, alerta que o conceito de empatia é mais amplo do que este estudo pode cristalizar. A comunicação escrita não é igual à comunicação presencial, nem as dúvidas são levantadas no contexto de uma rede social do que numa consulta. “Quando falamos de empatia, falamos de muitos temas. No momento, é difícil substituir a linguagem não verbal, que é muito importante quando um médico tem que conversar com um paciente ou sua família”, aponta. Mas ele admite o potencial dessas ferramentas generativas para fundamentar o jargão médico, por exemplo: “Na comunicação escrita, a linguagem técnica médica pode ser complexa e podemos ter dificuldade em traduzi-la para uma linguagem compreensível. Provavelmente, esses algoritmos encontram a equivalência entre a palavra técnica e outra adaptada ao receptor”.

Joan Gibert, bioinformática e referência no desenvolvimento de modelos de IA no Hospital del Mar de Barcelona, acrescenta outra variável ao avaliar a potencial empatia da máquina para com o médico. “No estudo, misturam-se dois conceitos que entram na equação: o próprio ChatGPT, que pode ser útil em determinados cenários e que tem a capacidade de concatenar palavras que nos dão a sensação de que é mais empático, e o esgotamento dos médicos, aquele esgotamento emocional na hora de atender o paciente que não deixa o clínico ter mais capacidade de empatia”, explica.

O perigo das “alucinações”

Em todo o caso, e tal como acontece com o famoso médico Google, você sempre deve ter cuidado com as respostas que o ChatGPT lança, por mais sensível ou amigável que pareça. Especialistas lembram que o chatbot ele não é médico e pode falhar. Ao contrário de outros algoritmos, o ChatGPT é generativo, ou seja, cria informações a partir dos bancos de dados com os quais foi treinado, mas pode inventar algumas das respostas que lança. “É preciso sempre ter em mente que não é uma entidade independente e não pode servir como ferramenta de diagnóstico sem supervisão”, insiste Gibert.

Esses bate-papos podem sofrer do que os especialistas chamam de “alucinações”, explica o bioinformático del Mar: “Dependendo das situações, ele conta algo que não é verdade. O chat junta as palavras de forma que tenham coerência e por ter muita informação, pode ser valioso. Mas tem que ser checado porque senão pode alimentar o notícias falsas”. Munuera também destaca a importância de “conhecer a base de dados que treinou o algoritmo porque se as bases de dados forem insuficientes, a resposta também será insuficiente”.

“Você tem que entender que quando você pede para ele te dar um diagnóstico, ele pode inventar uma doença”

Josep Munuera, Hospital Sant Pau em Barcelona

Na rua, os potenciais usos do ChatGPT em saúde são limitados, pois as informações que eles fornecem podem levar a erros. Jose Ibeas, nefrologista do Hospital Parc Taulí de Sabadel e secretário do Grupo de Big Data e Inteligência Artificial da Sociedade Espanhola de Nefrologia, destaca que é “útil para as primeiras camadas de informação porque sintetiza informação e ajuda, mas quando você entra em uma área mais específica, em patologias mais complexas, a utilidade é mínima ou errada”. Munuera concorda e enfatiza que “não é um algoritmo que ajuda a tirar dúvidas”. “Você tem que entender que quando você pede para ele fazer um diagnóstico diferencial, ele pode inventar uma doença”, alerta. E, da mesma forma, o algoritmo pode responder às dúvidas de um cidadão concluindo que não é nada grave quando, na realidade, é: aí pode perder-se uma oportunidade de cuidados de saúde porque a pessoa fica satisfeita com a resposta do chatbot e não consulta um médico de verdade.

Onde os especialistas encontram mais espaço de manobra nessas aplicações é como uma ferramenta de suporte para profissionais de saúde. Por exemplo, para ajudar a responder às perguntas do paciente por escrito, embora sempre sob a supervisão do médico. O estudo de Jama Medicina Interna Ele argumenta que isso ajudaria a “melhorar o fluxo de trabalho” e os resultados dos pacientes: “Se mais perguntas dos pacientes forem respondidas com rapidez, empatia e alto nível, isso poderá reduzir as visitas desnecessárias à clínica, liberando recursos para quem precisa”. Além disso, as mensagens são um recurso crítico para promover a equidade do paciente, onde as pessoas com limitações de mobilidade ou horários de trabalho irregulares têm maior probabilidade de recorrer às mensagens”, concordam os autores.

A comunidade científica também estuda o uso dessas ferramentas para outras tarefas repetitivas, como capas de planilhas e relatórios. “Partindo da premissa de que tudo sempre, sempre, sempre precisará ser revisto pelo médico”, destaca Gibert, o apoio em tarefas burocráticas —repetitivas, mas importantes— libera tempo para que os médicos se dediquem a outras questões, como a própria paciente. Um artigo publicado em The Lancet levanta, por exemplo, seu potencial para agilizar os relatórios de alta: automatizar esse processo poderia aliviar a carga de trabalho e até melhorar a qualidade dos relatórios, embora eles estejam cientes, dizem os autores, das dificuldades em treinar algoritmos com bancos de dados extensos e, entre outros problemas , o risco de “despersonalização do atendimento”, algo que poderia gerar resistência a essa tecnologia.

O Ibeas insiste que, para qualquer uso médico, essa classe de ferramentas deve ser “validada” e a distribuição de responsabilidades deve ser bem estabelecida: “Os sistemas nunca vão decidir. Quem sempre assina no final é o médico”, diz.

problemas éticos

Gibert também aponta algumas considerações éticas que devem ser levadas em conta ao desembarcar essas ferramentas na prática clínica: “Você precisa que esse tipo de tecnologia esteja sob um guarda-chuva legal, que existam soluções integradas dentro da estrutura hospitalar e garanta que os dados de os pacientes não são usados para retreinar o modelo. E se alguém quiser fazer isso, deve fazê-lo dentro de um projeto, com dados anônimos e seguindo todos os controles e regulamentos. Informações confidenciais do paciente não podem ser compartilhadas de maneira rude”.

O bioinformático aponta ainda que estas soluções de IA, como o ChatGPT ou modelos que auxiliam no diagnóstico, introduzem “vieses” no dia-a-dia do médico. Por exemplo, isso condiciona a decisão do médico, de uma forma ou de outra. “O fato de o profissional ter o resultado de um modelo de IA modifica o próprio avaliador: a forma de se relacionar pode ser muito boa, mas pode trazer problemas, principalmente em profissionais com menos experiência. Por isso o processo tem que ser feito em paralelo: até o profissional dar o diagnóstico, ele não consegue ver o que a IA fala”.

Um grupo de pesquisadores da Universidade de Stanford também refletiu em um artigo na Jama Medicina Interna sobre como essas ferramentas podem ajudar a humanizar ainda mais a assistência à saúde: “O exercício da medicina é muito mais do que processar informações e associar palavras a conceitos; é atribuir significado a esses conceitos enquanto se conecta com os pacientes como um parceiro confiável na construção de vidas mais saudáveis. Podemos esperar que os sistemas emergentes de IA possam ajudar a domar as tarefas laboriosas que sobrecarregam a medicina moderna e capacitar os médicos a se concentrarem novamente no tratamento de pacientes humanos”.

Esperando para ver como essa tecnologia incipiente se expande e quais são suas repercussões para o público, Munuera insiste: “Você tem que entender que [ChatGPT] não é uma ferramenta médica e não há profissional de saúde que possa confirmar a veracidade da resposta. Tem que ser prudente e entender quais são os limites”. Em resumo, Ibeas continua: “O sistema é bom, robusto, positivo e é o futuro, mas como qualquer ferramenta, é preciso saber usar para que não vire uma arma”.

você pode seguir O PAÍS Saúde e bem-estar em Facebook, Twitter e Instagram.

Com informações do EL Pais / Tecnología

Compartilhe este post